Aufmerksamkeit ist alles, was Sie brauchen - das Transformer-Modell

Nehmen wir den Chatbot ChatGPT als Beispiel. Das "T" in "GPT" steht für Transformer, eine Architektur, die von einem Teilbereich der natürlichen Sprachverarbeitung (NLP) verwendet wird, dem Large Language Model, kurz LLM. LLM hat sich zur vorherrschenden Methode entwickelt, um Computern das Lesen und Schreiben wie Menschen beizubringen, da es in der Lage ist, sich selbst durch Deep Learning und künstliche neuronale Netze (ANN) auf einem großen Korpus von unbeschriftetem Text zu "trainieren" (eine Wortzahl, die in die Billionen geht). Einfacher ausgedrückt: Er hat sich selbst das Lesen und Schreiben beigebracht, indem er die entsprechende Datenbank der gesamten Wikipedia analysiert hat, und ist daher in der Lage, sich über so gut wie jedes Thema zu unterhalten. Der Teil, bei dem er auf sein früheres Training zurückgreift, um auf Anfragen zu antworten, wird "Inferenz" genannt.

Wie funktioniert also Stable Diffusion oder Midjourney oder eines der unzähligen Text-Bild-Modelle? Nicht viel anders als bei ChatGPT, nur dass dieses Mal ein generatives Bildmodell an das Sprachmodell angehängt ist. Diese Modelle wurden ebenfalls mit einer großen Anzahl digitaler Texte und Bilder trainiert, so dass die KI in der Lage ist, Bilder in Text umzuwandeln (mit Worten zu beschreiben, was auf einem Bild zu sehen ist) oder umgekehrt.

Training: Wie es funktioniert, welche Tools zu verwenden sind

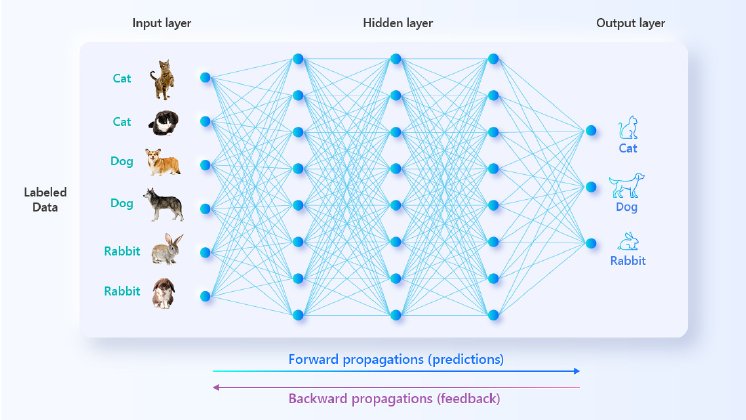

Es gibt einen Grund, warum sich der moderne Bereich des maschinellen Lernens stark an die neurowissenschaftliche Terminologie anlehnt - dieser Zweig der KI-Entwicklung profitiert stark vom Verständnis des menschlichen Gehirns. Das menschliche Gehirn besteht aus Milliarden von Neuronen, die durch die Bildung von Billionen von Synapsen miteinander kommunizieren. Das ANN besteht ebenfalls aus Schichten und Schichten von Knoten, die biologischen Neuronen nachempfunden sind; die Verbindungen zwischen ihnen sind unseren Synapsen ähnlich.

Wenn ein Datenelement von Schicht zu Schicht weitergegeben wird, wird den Datenparametern je nach Gültigkeit der Ausgabe eine gewichtete Punktzahl zugewiesen. Durch wiederholte Iterationen von Vorhersagen (Vorwärtspropagation) und Rückkopplungen (Rückwärtspropagation) werden die Gewichtungen so präzise, dass immer die richtigen Verbindungen gewählt werden. Um eine grobe Analogie zu verwenden, kann man sich das so vorstellen, dass die zuvor analysierten Daten "Rillen" im Algorithmus hinterlassen, denen künftige Daten folgen. Obwohl die KI also keine Eingabebefehle im wörtlichen Sinne versteht, hat sie das Raten über einen so langen Zeitraum mit so vielen Daten geübt, dass sie eine geschulte Reaktion auf neue Eingaben, sei es in Form von Texten oder Bildern, erzeugen kann.

Frühere Trainingsmethoden stützten sich auf "markierte" Daten und wurden von menschlichen Programmierern überwacht - das heißt, es war viel Handarbeit nötig. Jüngste Fortschritte haben es der KI jedoch ermöglicht, selbstüberwachtes oder halbüberwachtes Lernen mit unmarkierten Daten durchzuführen, wodurch der Prozess erheblich beschleunigt wurde. Der Umfang der für das Training der KI erforderlichen Rechenressourcen ist nicht nur atemberaubend, sondern steigt auch exponentiell an. GPT-1, das 2018 veröffentlicht wurde, trainierte beispielsweise "einen Monat lang auf 8 GPUs" und verbrauchte etwa 0,96 Petaflop/s-Tage (pfs-Tage) an Ressourcen. GPT-3, das im Jahr 2020 veröffentlicht wurde, verbrauchte 3.630 pfs-Tage an Ressourcen. Für die aktuelle Iteration von GPT-4 sind keine Zahlen verfügbar, aber es besteht kein Zweifel, dass der Zeit- und Rechenaufwand um Größenordnungen höher war als bei GPT-3.

Daher wird für das KI-Training eine leistungsstarke GPU-Computing-Plattform benötigt. GPUs werden bevorzugt, weil sie sich durch paralleles Rechnen bei der Verarbeitung großer Datenmengen auszeichnen. Dank der Parallelisierung kann die oben erwähnte Transformer-Architektur alle sequentiellen Daten, die Sie ihr zuführen, auf einmal verarbeiten. Für den anspruchsvollen KI-Experten kann sogar die Art der Kerne in der GPU einen Unterschied machen, wenn es darum geht, die Zeit, die für das Training der KI benötigt wird, weiter zu verkürzen.

Inferenz: Wie es funktioniert, welche Tools zu verwenden sind

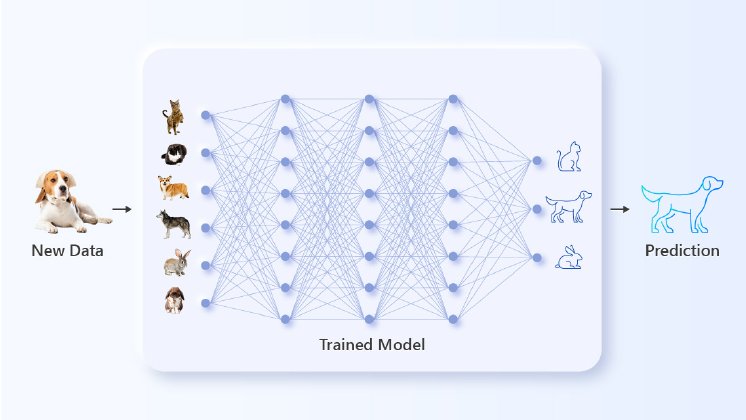

Sobald die KI ordnungsgemäß trainiert und getestet wurde, ist es an der Zeit, mit der Inferenzphase fortzufahren. Die KI wird massiven Mengen neuer Daten ausgesetzt, um zu sehen, ob ihr trainiertes Neuronennetz eine hohe Genauigkeit für das beabsichtigte Ergebnis erzielen kann. Im Falle der generativen KI kann dies alles sein, vom Schreiben eines Science-Fiction-Romans bis zum Malen eines Bildes einer ultrarealistischen Landschaft mit verschiedenen künstlerischen Elementen.

Die KI vergleicht die Parameter dieser neuen Eingaben mit dem, was sie während ihres umfangreichen Trainingsprozesses "gelernt" hat, und erzeugt die entsprechende Ausgabe. Während diese Vorwärts- und Rückwärtsverschiebungen zwischen den Schichten stattfinden, geschieht etwas anderes Interessantes. Die KI sammelt die Antworten, die sie von den menschlichen Nutzern erhält, für ihre nächste Trainingssitzung. Sie nimmt zur Kenntnis, wenn sie für eine gut gemachte Arbeit gelobt wird, und sie ist besonders aufmerksam, wenn der Mensch ihre Leistung kritisiert. Diese kontinuierliche Schleife aus Training und Schlussfolgerungen macht die künstliche Intelligenz jeden Tag intelligenter und lebensechter.

Rechenressourcen und GPU-Beschleunigung sind nach wie vor wichtig, wenn es um Schlussfolgerungen geht, aber jetzt kommt noch ein weiterer Aspekt hinzu: die Latenzzeit. Die Nutzer verlangen schnelle Antworten von der KI, vor allem, wenn viele der von der KI generierten Inhalte noch fein abgestimmt werden müssen, bevor sie von Nutzen sein können. In anderen Szenarien außerhalb der generativen KI kann eine schnelle Antwort die Produktivität oder sogar die Sicherheit beeinträchtigen (z. B. beim Einsatz von Computer Vision zum Sortieren von Post oder zum Navigieren eines selbstfahrenden Postwagens), so dass es noch wichtiger ist, die Latenzzeit zu minimieren.

Die Rolle der CPU beim GPU-Computing - mit AMD EPYC™ 9004 Sereis "Genoa"-Prozessoren

Sowohl beim Trainingsprozess als auch beim Inferencing-Prozess sind neben der Wahl des/der geeigneten GPU-Modells/Grafikprozessoren die geringste Latenz und die größte Bandbreite der Datenbewegung von entscheidender Bedeutung für die Leistungsoptimierung. Diese Aussage gilt insbesondere, wenn der Aspekt der Datenaffinität / Lokalität diskutiert wird: Trainingsdaten so nah wie möglich an der GPU zu haben oder Inferenzdaten zu verarbeiten, bevor sie der GPU präsentiert werden, erfordert viele schnelle, leistungsstarke CPU-Kerne. Die AMD Genoa CPU-Prozessoren übernehmen in diesem Zusammenhang wichtige Aufgaben wie die Verarbeitung von Datenabfragen, die Übersetzung von physischen und virtuellen Speicheradressen, die Analyse und den Vergleich von relationalen Metadaten, die Konvertierung von Datenformaten, die Ver- und Entschlüsselung von Daten über das Netzwerk, die Aggregation von Ergebnissen, die von der GPU berechnet wurden, und die Aktualisierung von Modellen über Cluster von Knoten usw.. Aus diesem Grund sind die beiden Flaggschiff-GPU-Serverplattformen von GIGABYTE / Giga Computing, G593-ZD2 und G293-Z43, mit der AMD EPYC™ 9004 Sereis "Genoa"-Architektur ausgestattet.

G593-ZD2 mit zwei AMD Genoa Prozessoren - für Trainingsworkloads

Die integrierten 8x NVIDIA HGX™ H100 GPU-Module werden von zwei AMD Genoa CPU-Prozessoren beschleunigt (bis zu 128 Kerne pro CPU / 256 Threads pro CPU und bis zu 400W cTDP pro CPU). GIGABYTE war in der Lage, all diese Rechenleistung in einem 5U-Server unterzubringen, dank seiner proprietären Kühltechnologie und dem Gehäusedesign, so dass Kunden eine unglaubliche Rechendichte bei minimalem Platzbedarf genießen können.

G293-Z43 mit zwei AMD Genoa Prozessoren - für Inferenz-Workloads

Eine der besten GIGABYTE Lösungen für KI-Inferenz ist das G293-Z43, das eine hochdichte Konfiguration von Inferenzbeschleunigern beherbergt, mit bis zu sechzehn Inferenz-GPU-Karten in einem 2U-Gehäuse. Die GPU-Karten werden durch die beiden integrierten AMD Genoa CPU-Prozessoren, die für KI-Inferenz optimiert sind, weiter beschleunigt. Die adaptive Datenflussarchitektur ermöglicht es, Informationen zwischen den Schichten eines KI-Modells zu übertragen, ohne auf externen Speicher zurückgreifen zu müssen. Dank der hohen CPU-Kerndichte der AMD Genoa-Serie werden dadurch Leistung und Energieeffizienz verbessert und gleichzeitig die Latenzzeiten verringert.

Es ist wichtig anzumerken, dass KI-Training und Inferencing schon lange vor der Aufmerksamkeit des Marktes für generative KI stattgefunden haben. Kunden, die KI-Modelle entwickeln und einsetzen, entscheiden sich häufig für GIGABYTEs branchenführende GPU-Server der G-Serie, die Edge-Server der E-Serie und die Rack-Server der R-Serie.

Fazit

Generative KI findet ihren Weg in alle Bereiche der menschlichen Welt, vom Einzelhandel und der Fertigung bis hin zum Gesundheitswesen und dem Bankwesen. Die Serverlösungen hängen davon ab, welchen Teil des generativen KI-Entwicklungsprozesses KI-Experten verbessern möchten - ob es sich um die Verarbeitung von Daten zum "Trainieren" von KI oder um die Bereitstellung des KI-Modells handelt, damit es in der realen Welt "schlussfolgern" kann. Von etwas so Kleinem wie der Architektur von Prozessorkernen bis hin zu etwas so Umfassendem wie den Gesamtlösungen von GIGABYTE Technology sind die Instrumente zum Erreichen des Erfolgs vorhanden.

Vielen Dank für die Lektüre von GIGABYTEs Tech Guide zum Thema "Generative AI: Training & Inference". Wir hoffen, dass dieser Artikel hilfreich und informativ war. Für weitere Beratung darüber, wie Sie von KI in Ihrer Geschäftsstrategie, akademischen Forschung oder öffentlichen Politik profitieren können, wenden Sie sich bitte an unsere Vertriebsmitarbeiter unter server.grp@gigacomputing.com.